实时同步概述

什么是实时同步?

这里的实时同步实质上是使用一个服务监听指定目录,只要该目录发生变化则会触发一个事件,事件触发后会将变化的目录同步至远程服务器,而 sersync 就是一个可以监听指定目录的服务。

为什么要实时同步?

保证数据的连续性,减少人力维护成本,解决 nfs 单点故障。

实时同步工具

提到数据同步就必然会谈到 rsync,一般简单的服务器数据传输会使用 ftp/sftp 等方式,但是这样的方式效率不高,不支持差异化增量同步也不支持实时传输。

inotify 是一个通知接口,用来监控文件系统的各种变化,如果指定目录有文件存取,删除,移动,可以非常方便地实现文件异动告

警,针对目录或文件的变化及时作出响应,rsync 结合 inotify 一起使用可以实触发式实时同步增量备份。

sersync 是国人基于前两者开发的工具,不仅保留了优点同时还强化了实时监控,文件过滤,简化配置等功能,帮助用户提高运行效率,节省时间和网络资源,是一种可靠高效的数据实时同步方式。

sersync 的 github 地址:https://github.com/wsgzao/sersync。

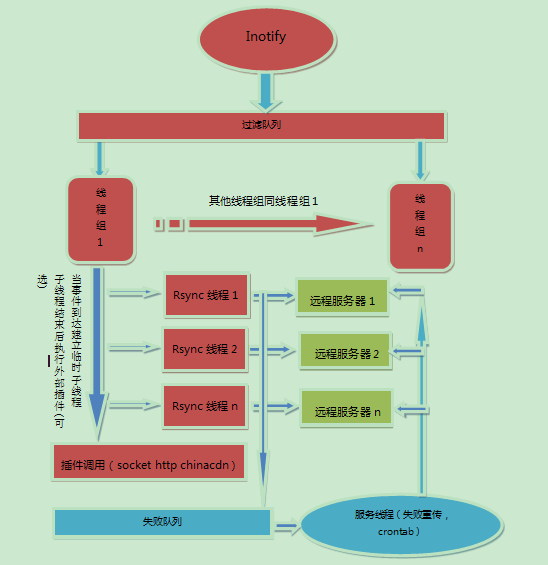

sersync 原理

sersync 主要用于服务器同步,web 镜像等功能。基于 boost1.43.0、inotify api、rsync command 开发。目前使用的比较多的同步解决方案是 inotify-tools + rsync,另外一个是 google 开源项目 Openduckbill(依赖于 inotify- tools),这两个都是基于脚本语言编写的。相比较上面两个项目,本项目优点是:

- sersync 是使用 c++ 编写,而且对 linux 系统文件系统产生的临时文件和重复的文件操作进行过滤,所以在结合 rsync 同步的时候,节省了运行时耗和网络资源,因此更快。

- 相比较上面两个项目,sersync 配置起来很简单,其中 bin 目录下已经有基本上静态编译的二进制文件,配合 bin 目录下的 xml 配置文件直接使用即可。

- 另外本项目相比较其他脚本开源项目,使用多线程进行同步,尤其在同步较大文件时,能够保证多个服务器实时保持同步状态。

- 本项目有出错处理机制,通过失败队列对出错的文件重新同步,如果仍旧失败,则按设定时长对同步失败的文件重新同步。

- 本项目自带 crontab 功能,只需在 xml 配置文件中开启,即可按您的要求,隔一段时间整体同步一次。无需再额外配置 crontab 功能。

- 本项目有 socket 与 http 插件扩展,满足您二次开发的需要。

针对上图的设计架构,这里做几点说明,来帮助大家阅读和理解该图

1 ) 线程组线程是等待线程队列的守护线程,当事件队列中有事件产生的时候,线程组守护线程就会逐个唤醒同步线程。当队列中 inotify 事件较多的时候,同步线程就会被全部唤醒一起工作。这样设计的目的是为了能够同时处理多个 inotify 事件,从而提升服务器的并发同步能力。同步线程的最佳数量=核数 x 2 + 2。

2 ) 那么之所以称之为线程组线程,是因为每个线程在工作的时候,会根据服务器上新写入文件的数量去建立子线程,子线程可以保证所有的文件与各个服务器同时同步。当要同步的文件较大的时候,这样的设计可以保证每个远程服务器都可以同时获得需要同步的文件。 3 ) 服务线程的作用有三个:

- 处理同步失败的文件,将这些文件再次同步,对于再次同步失败的文件会生成 rsync_fail_log.sh 脚本,记录失败的事件。

- 每隔10个小时执行 rsync_fail_log.sh 脚本一次,同时清空脚本。

- crontab 功能,可以每隔一定时间,将所有路径整体同步一次。

4 ) 过滤队列的建立是为了过滤短时间内产生的重复的 inotify 信息,例如在删除文件夹的时候,inotify 就会同时产生删除文件夹里的文件与删除文件夹的事件,通过过滤队列,当删除文件夹事件产生的时候,会将之前加入队列的删除文件的事件全部过滤掉,这样只产生一条删除文件夹的事件,从而减轻了同步的负担。同时对于修改文件的操作的时候,会产生临时文件的重复操作。

sersync 实时同步实践

在开始下面实践之前需要对 NFS 有一定的了解,可参考【网络文件共享服务(4)之NFS网络文件系统】。

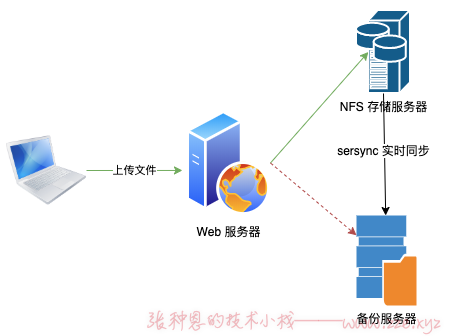

案例:

- Web 服务器使用 Apache httpd 提供 Web 访问入口;

- NFS 服务器导出指定目录(

/data)给 Web 服务器挂载(挂载点为/var/www/html/upload),Web 服务器接收上传的文件保存至挂载点; - NFS 服务器使用 sersync 监控导出的目录(

/data),出现变化时将变化同步到备份服务器的指定目录/data,这里备份服务器需要开启 rsync 守护进程模式; - 当 NFS 存储服务器出现故障时备份服务器需要充当 NFS 服务器的角色,所以备份服务器也要开启 NFS 服务;

架构图如下:

在上图中,客户端通过 Web 服务器上传文件:

- 正常情况下 Web 服务器直接将文件保存至 NFS 服务器(绿线);

- 当 NFS 存储服务器出现故障时,自动切换备份服务器为存储服务器(红色虚线)。

这里对各个服务器地址及服务规划如下:

| 服务器 | 主机名 | IP | 服务 |

|---|---|---|---|

| Web 服务器 | web01 | 172.16.1.7 | Apache httpd |

| NFS 存储服务器 | nfs | 172.16.1.31 | NFS、sersync |

| 备份服务器 | backup | 172.16.1.41 | NFS、rsync |

下面我们就开始吧~~

通用操作

在备份服务器、NFS 服务器、Web 服务器上都创建一个 www 用户,如下:

$ groupadd -g 666 www

$ useradd -u 666 -g 666 -s /sbin/nologin -M www

备份服务器

rsync 服务

rsync 的详细使用可参见上篇文章,点击这里直达。

1、安装 rsync:

$ yum install rsync -y

2、创建备份目录并修改其属主属组:

$ mkdir /data && chown www.www -R /data

3、编辑 /etc/rsyncd.conf 配置文件如下:

uid = www

gid = www

port = 873

fake super = yes

use chroot = no

max connections = 200

timeout = 600

ignore errors

read only = false

list = false

auth users = rsync_backup

secrets file = /etc/rsync.passwd

log file = /var/log/rsyncd.log

[backup]

comment = backup for server config file

path = /backup

[data]

comment = backup for NFS

path = /data

4、配置虚拟用户密码:

$ echo 1 > /etc/rsync.passwd

5、将 rsync 服务设定开机自启并启动:

$ systemctl enable rsyncd && systemctl start rsyncd

NFS 服务

1、安装 NFS 工具包:

$ yum install nfs-utils -y

2、编辑配置文件导出 /data 目录:

echo '/data 172.16.1.0/24(rw,all_squash,sync,anonuid=666,anongid=666)' > /etc/exports

3、将 NFS 设定开机自启并启动:

$ systemctl enable nfs-server && systemctl start nfs-server

$ cat /var/lib/nfs/etab

/data 172.16.1.0/24(rw,sync,wdelay,hide,nocrossmnt,secure,root_squash,all_squash,no_subtree_check,secure_locks,acl,no_pnfs,anonuid=666,anongid=666,sec=sys,rw,secure,root_squash,all_squash)

NFS 服务器

NFS 服务

1、创建 Web 资源存放的目录修改器属主属组:

$ mkdir /data && chown www.www -R /data

2、重复备份服务器中 NFS 服务的操作。

sersync 服务

1、由于 sersync 需要依赖 inotify 和 rsync,所以需要先安装它们:

$ yum install rsync inotify-tools -y

2、下载 sersync 程序包,解压并将其可执行程序文件加入 PATH 路径:

$ wget https://github.com/wsgzao/sersync/blob/master/sersync2.5.4_64bit_binary_stable_final.tar.gz

$ tar xf sersync2.5.4_64bit_binary_stable_final.tar.gz

$ mv GNU-Linux-x86 /usr/local/sersync && ln -s /usr/local/sersync/sersync2 /usr/local/bin/sersync

上不了 github 的同学可以关注文章首部微信公众号发送

#sersync获取百度网盘下载链接。

3、编辑配置文件,这里的配置文件就是可执行程序同目录下的 XML 文件,备份一下该文件,修改配置如下:

$ cd /usr/local/sersync/ && cp confxml.xml{,.bak} && vim confxml.xml

<?xml version="1.0" encoding="ISO-8859-1"?>

<head version="2.5">

<!-- hostip 与 port 是针对插件的保留字段,对于同步没有任何作用,保留默认即可。-->

<host hostip="localhost" port="8008"></host>

<!-- 开启 debug 模式,会在 sersync 正在运行的控制台,打印 inotify 事件与 rsync 同步命令。-->

<debug start="false"/>

<!-- 对于 xfs 文件系统的用户,需要将这个选项开启,才能是 sersync 正常工作。-->

<fileSystem xfs="false"/>

<!-- 对于 sersync 监控的文件,会默认过滤系统的临时文件(以"."开头,以"~"结尾),除了这些文件外,可以自定义其他需要过滤的文件,如下,支持正则匹配。-->

<filter start="false">

<exclude expression="(.*)\.svn"></exclude>

<exclude expression="(.*)\.gz"></exclude>

<exclude expression="^info/*"></exclude>

<exclude expression="^static/*"></exclude>

</filter>

<!-- 指定监听的动作,控制在指定目录中出现指定类型操作时是否同步到远程主机。-->

<inotify>

<!-- 删除 -->

<delete start="false"/>

<!-- 创建文件夹 -->

<createFolder start="true"/>

<!-- 创建文件 -->

<createFile start="false"/>

<!-- 关闭写入 -->

<closeWrite start="true"/>

<!-- 移入 -->

<moveFrom start="true"/>

<!-- 移出 -->

<moveTo start="true"/>

<!-- 修改文件属性 -->

<attrib start="false"/>

<!-- 修改文件内容 -->

<modify start="true"/>

</inotify>

<!--

这里多说一句,对于 inotify 监控参数,对于大多数应用,可以把 createFile 设置为 false 来提高性能,减少 rsync 通讯,

因为拷贝文件到监控目录会触发 createFile 事件与 closeWrite 事件,所以如果关闭 create 事件,只监控文件拷贝时结束的事件 close_write,同样可以实现文件完整同步。

注意:要将 createFolder 保持为 true,如果将 createFloder 设置为 false,则不会对产生的目录进行监控,该目录下的子文件与子目录也不会被监控,所以除非特殊需要,请开启。

默认情况下对创建文件(目录)事件与删除文件(目录)事件都进行监控,如果项目中不需要删除远程目标服务器的文件(目录),则可以将 delete 参数设置为 false,则不会对删除事件监控。

-->

<sersync>

<!-- 通过 watch 属性指定监听的本地目录。-->

<localpath watch="/data">

<!-- 当父节点指定的本地目录发生变化时同步到备份服务器,ip 指定远程服务器地址,name 指定远程服务器的 rsync 服务模块名。

这里的推送实际上是借助 rsync 完成的,所以这个模块名其实就是 rsync 配置文件中配置的模块名。-->

<remote ip="172.16.1.41" name="data"/>

</localpath>

<rsync>

<!-- 执行 rsync 命令时使用的参数。-->

<commonParams params="-az"/>

<!-- 指定 rsync 认证的虚拟用户名和密码文件位置。 -->

<auth start="true" users="rsync_backup" passwordfile="/etc/rsync.passwd"/>

<!-- 指定备份服务器 rsync 服务监听的端口,默认为 873。-->

<userDefinedPort start="false" port="874"/><!-- port=874 -->

<!-- 设定同步超时时间。-->

<timeout start="false" time="100"/><!-- timeout=100 -->

<!-- 指定是否已 ssh 方式传输,即 rsync -e ssh。-->

<ssh start="false"/>

</rsync>

<!-- 失败日志脚本配置,如果文件同步失败,会重新传送,再次失败就会写入 rsync_fail_log.sh,然后每隔一段时间(timetoexecute 进行设置,默认 60 分钟)

执行该脚本再次重新传送,执行成功后清空该脚本。-->

<failLog path="/tmp/rsync_fail_log.sh" timeToExecute="60"/><!--default every 60mins execute once-->

<!-- 每隔一段时间整体同步,如果文件量比较大,crontab 的时间间隔要设的大一些,否则可能增加通讯开销。-->

<crontab start="false" schedule="600"><!--600mins-->

<!-- 如果开启了 filter 文件过滤功能,那么 crontab 整体同步也需要设置过滤,否则虽然实时同步的时候文件被过滤了,但 crontab 整体同步的时候,

如果不单独设置 crontabfilter,还会将需要过滤的文件同步到远程服务器,crontab 的过滤规则与 fileter 过滤的不同。-->

<crontabfilter start="false">

<exclude expression="*.php"></exclude>

<exclude expression="info/*"></exclude>

</crontabfilter>

</crontab>

<!-- 设置为 true,将文件同步到远程服务器后会条用 name 参数指定的插件。如果需要使用插件则需要在启动实例的时候加上 -m 参数。 -->

<plugin start="false" name="command"/>

</sersync>

<!-- 当同步文件完成后,会调用 command 插件。-->

<plugin name="command">

<!-- 如监控目录中的 test.php 文件发生改变时,会调用 rsync 同步到远程服务器,然后,调用 comand 插件,以 prefix test.php suffix 格式执行。

如果配置如下则是执行 /bin/sh test.php 。如果 ignoError 为 true,则会添加 >/dev/null 2>&1,当然还可以设置 command 的 filter,

当 filter 为 true,include 可以只对正则匹配到的文件调用 command。-->

<param prefix="/bin/sh" suffix="" ignoreError="true"/>

<filter start="false">

<include expression="(.*)\.php"/>

<include expression="(.*)\.sh"/>

</filter>

</plugin>

<!-- 向指定 ip 与端口发送 inotify 所产生的文件路径信息。-->

<plugin name="socket">

<localpath watch="/opt/tongbu">

<deshost ip="192.168.138.20" port="8009"/>

</localpath>

</plugin>

<!-- 在同步的过程中将文件发送到目的服务器后刷新 cdn 接口。该模块使用的是 chinaCDN 协议进行设计,当有文件产生的时候,就向 cdn 接口发送需要刷新的路径位置。 -->

<plugin name="refreshCDN">

<!-- localpath 是需要监控的目录,cdninfo 标签指定了 cdn 接口的域名,端口号,以及用户名与密码。

sendurl 标签是需要刷新的 url 的前缀。regexurl 标签中的,regex 属性为 true 时,使用 match 属性的正则语句匹配 inotify 返回的路径信息,并将正则匹配到的部分作为 url 一部分。

如果产生事件的文件为:/data0/htdocs/cms.xoyo.com/site/jx3.xoyo.com/images/a/123.txt

经过下面的 match 正则匹配后,最后刷新的路径是:http://pic.xoyo.com/cms/jx3/a/123.txt

如果 regex 属性为 false,最后刷新的路径是:http://pic.xoyo.com/cms/jx3.xoyo.com/images/a/123.txt

-->

<localpath watch="/data0/htdocs/cms.xoyo.com/site/">

<cdninfo domainname="ccms.chinacache.com" port="80" username="xxxx" passwd="xxxx"/>

<sendurl base="http://pic.xoyo.com/cms"/>

<regexurl regex="false" match="cms.xoyo.com/site([/a-zA-Z0-9]*).xoyo.com/images"/>

</localpath>

</plugin>

</head>

4、添加备份服务器中 rsync 服务虚拟用户的密码文件:

$ echo "1" >/etc/rsync.passwd

$ chmod 600 /etc/rsync.passwd

5、使用 -h 选项查看 sersync 的帮助:

$ sersync -h

set the system param

execute:echo 50000000 > /proc/sys/fs/inotify/max_user_watches

execute:echo 327679 > /proc/sys/fs/inotify/max_queued_events

parse the command param

_______________________________________________________

参数-d:启用守护进程模式

参数-r:在监控前,将监控目录与远程主机用rsync命令推送一遍

参数-n: 指定开启守护线程的数量,默认为10个

参数-o:指定配置文件,默认使用confxml.xml文件

参数-m:单独启用其他模块,使用 -m refreshCDN 开启刷新CDN模块

参数-m:单独启用其他模块,使用 -m socket 开启socket模块

参数-m:单独启用其他模块,使用 -m http 开启http模块

不加-m参数,则默认执行同步程序

6、启动:

$ sersync -dro /usr/local/sersync/confxml.xml

set the system param

execute:echo 50000000 > /proc/sys/fs/inotify/max_user_watches

execute:echo 327679 > /proc/sys/fs/inotify/max_queued_events

parse the command param

option: -d run as a daemon

option: -r rsync all the local files to the remote servers before the sersync work

option: -o config xml name: /usr/local/sersync/confxml.xml

daemon thread num: 10

parse xml config file

host ip : localhost host port: 8008

will ignore the inotify delete event

daemon start,sersync run behind the console

use rsync password-file :

user is rsync_backup

passwordfile is /etc/rsync.passwd

config xml parse success

please set /etc/rsyncd.conf max connections=0 Manually

sersync working thread 12 = 1(primary thread) + 1(fail retry thread) + 10(daemon sub threads)

Max threads numbers is: 22 = 12(Thread pool nums) + 10(Sub threads)

please according your cpu ,use -n param to adjust the cpu rate

------------------------------------------

rsync the directory recursivly to the remote servers once

working please wait...

execute command: cd /data && rsync -az -R ./ rsync_backup@172.16.1.41::data --password-file=/etc/rsync.passwd >/dev/null 2>&1

run the sersync:

watch path is: /data

由输出的倒数第四行可以看到其实 sersync 最后也是调用 rsync 命令来完成同步操作。

7、测试,在 NFS 服务器的 /data 目录创建文件,然后备份服务器的 /data 目录查看是否同步成功。如果没有备份成功,可以手动执行 sersync 输出的命令 cd /data && rsync -az -R ./ rsync_backup@172.16.1.41::data --password-file=/etc/rsync.passwd 进行排错。

Web 服务器

1、安装 NFS 工具包:

$ yum install nfs-utils

2、检查 NFS 服务器和备份服务器上的 NFS 服务是否正常:

$ showmount -e 172.16.1.31

Export list for 172.16.1.31:

/data 172.16.1.0/24

$ showmount -e 172.16.1.41

Export list for 172.16.1.41:

/data 172.16.1.0/24

3、安装 httpd 服务,因后面测试的上传文件程序是由 PHP 编写,所以 PHP 也一起安装:

$ yum install -y httpd php

4、编辑 /etc/httpd/conf/httpd.conf 修改 httpd 服务的傀儡用户为 www:

User www

Group www

5、上传测试程序到 Web 服务器(关注文章首部微信公众号发送 #sersync_web 即可获取),并解压它到 /var/www/html 中:

$ tar xf commit.tar.gz -C /var/www/html/

6、创建上传文件的保存目录(这个目录是程序中写死的,不能随意修改),并修改 httpd 的站点目录的属主属组:

$ mkdir /var/www/html/upload

$ chown www.www -R /var/www/html

7、挂载 NFS 服务器导出的 /data 目录到 Web 服务器的上传文件目录:

$ mount -t nfs 172.16.1.31:/data /var/www/html/upload

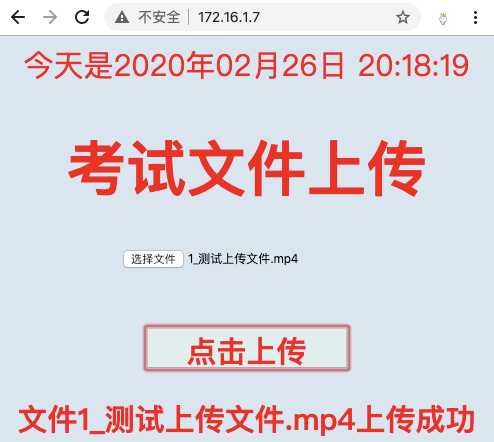

8、浏览器访问 Web 服务器(176.16.1.7),测试上传文件:

9、查看 NFS 服务器的 /data 目录是否有了新上传的文件:

$ find /data/

/data/

/data/2020-02-26

/data/2020-02-26/1_测试上传文件.mp4

10、查看备份服务器的 /data 目录是否同步了 NFS 服务器的 /data 目录:

$ find /data/

/data/

/data/2020-02-26

/data/2020-02-26/1_测试上传文件.mp4

大功告成~~~

自动切换到备份服务器

在 Web 服务器编写脚本如下:

#!/bin/bash

#

# 每 10 秒检查 NFS 服务器是否正常, 如果挂了则切换到备份服务器

trap 'onCtrlC' INT

function onCtrlC () {

echo '通过 Ctrl C 退出了' && exit 0

}

declare -i need_sync=1

check_nfs(){

ping -c2 -W1 172.16.1.31 &>/dev/null

if [ $? -ne 0 ];then

echo 'NFS 服务器挂了'

# echo 'NFS 挂了' | mail -s "check nfs" root@127.0.0.1 &> /dev/null

ping -c2 -W1 172.16.1.41 &>/dev/null

# 如果备份服务器正常

if [ $? -eq 0 ];then

echo '备份服务器正常'

cat /proc/mounts | grep '172.16.1.41:/data' > /dev/null

if [ $? -ne 0 ];then

echo '准备切换到备份服务器...'

umount -lf /var/www/html/upload &> /dev/null

mount -t nfs -o retry=1,timeo=3,bg,intr 172.16.1.41:/data /var/www/html/upload &> /dev/null

if [ $? -eq 0 ];then

echo '已切换到备份服务器'

else

echo '切换备份服务器失败'

fi

fi

else

echo '彻底凉凉, 备份服务器也挂了...跑路吧'

# echo '彻底凉凉!!!备份服务器都挂了' | mail -s "check backup" root@127.0.0.1 &> /dev/null

fi

else

cat /proc/mounts | grep '172.16.1.31:/data' &> /dev/null

# 如果 NFS 服务正常, 但没有挂载它

if [ $? -ne 0 ];then

echo 'NFS 服务器恢复正常了...'

cat /proc/mounts | grep '172.16.1.41:/data' &> /dev/null

is_mounted_backup=$?

echo '正在切换到 NFS 服务器...'

umount -lf /var/www/html/upload &> /dev/null

mount -t nfs 172.16.1.31:/data /var/www/html/upload > /dev/null

if [ $? -eq 0 ];then

echo '已切换到 NFS 服务器'

if [ $is_mounted_backup -eq 0 ];then

echo '准备同步备份服务器数据到 NFS 服务器'

rsync -az -R rsync_backup@172.16.1.41::data /var/www/html/upload --password-file=/etc/rsync.passwd &> /dev/null

if [ $? -eq 0 ];then

echo '同步备份服务器数据完毕'

else

echo '同步备份服务器数据失败'

need_sync=0

fi

fi

else

echo '切换到 NFS 服务器失败'

fi

fi

echo "NFS 服务器正常"

fi

}

while true;do

if [ $need_sync -eq 0 ];then

for (( i=1; i <= 3; i++ ))

do

echo "第 $i 次尝试同步备份服务器数据到 NFS 服务器"

rsync -az -R rsync_backup@172.16.1.41::data /var/www/html/upload --password-file=/etc/rsync.passwd &> /dev/null

if [ $? -eq 0 ];then

echo '同步备份服务器数据成功'

need_sync=1

break

else

echo "第 $i 次同步失败"

sleep 5

fi

done

fi

date +%H:%M:%S

check_nfs

sleep 10

done

效果如下:

$ bash check_nfs.sh

11:12:30

NFS 服务器挂了

备份服务器正常

准备切换到备份服务器...

已切换到备份服务器

11:12:43

NFS 服务器恢复正常了...

正在切换到 NFS 服务器...

已切换到 NFS 服务器

准备同步备份服务器数据到 NFS 服务器

同步备份服务器数据完毕

NFS 服务器正常

11:12:54

NFS 服务器挂了

备份服务器正常

准备切换到备份服务器...

已切换到备份服务器

11:19:08

NFS 服务器挂了

备份服务器正常

11:19:21

NFS 服务器恢复正常了...

正在切换到 NFS 服务器...

已切换到 NFS 服务器

准备同步备份服务器数据到 NFS 服务器

同步备份服务器数据失败

NFS 服务器正常

第 1 次尝试同步备份服务器数据到 NFS 服务器

第 1 次同步失败

第 2 次尝试同步备份服务器数据到 NFS 服务器

第 2 次同步失败

第 3 次尝试同步备份服务器数据到 NFS 服务器

同步备份服务器数据成功

11:20:32

NFS 服务器正常

11:20:48

NFS 服务器正常

^C通过 Ctrl C 退出了

不知道为啥在切换到备份服务器时一只要阻塞个好几分钟。。。。试着改了好多参数也没用。。。

实际使用可以修改一下上述脚本,把需要的输出信息通过邮件转给用户,然后执行下面命令把脚本丢到后台运行即可。

$ nohup bash check_nfs.sh &> /dev/null &

将 sersync 服务交给 systemd 管理

1、编写服务脚本如下:

$ vim /usr/lib/systemd/system/sersync.service

[Unit]

Description=sersync service

[Service]

Type=forking

ExecStart=/usr/local/sersync/sersync2 -rdo /usr/local/sersync/confxml.xml

ExecStop=/usr/bin/kill $MAINPID

StandardOutput=syslog

StandardError=inherit

[Install]

WantedBy=multi-user.target

2、接下来就可以使用如下操作了:

# 开机自启

$ systemctl enable sersync

# 启动

$ systemctl start sersync

# 查看状态

$ systemctl status sersync

# 重启

$ systemctl restart sersync

-de8bd8f33c3e44a59907dafe1884f228.png)

评论区